ollama

Ollama 是一个开源的大型语言模型服务,提供了类似 OpenAI 的 API 接口和聊天界面,可以非常方便地部署最新版本的 GPT 模型并通过接口使用。支持热加载模型文件,无需重新启动即可切换不同的模型。

注意:您应该至少有 8 GB 可用 RAM 来运行 7B 型号,16 GB 来运行 13B 型号,32 GB 来运行 33B 型号。

1、创建专属桥接网络

若已创建,可跳过此步骤。

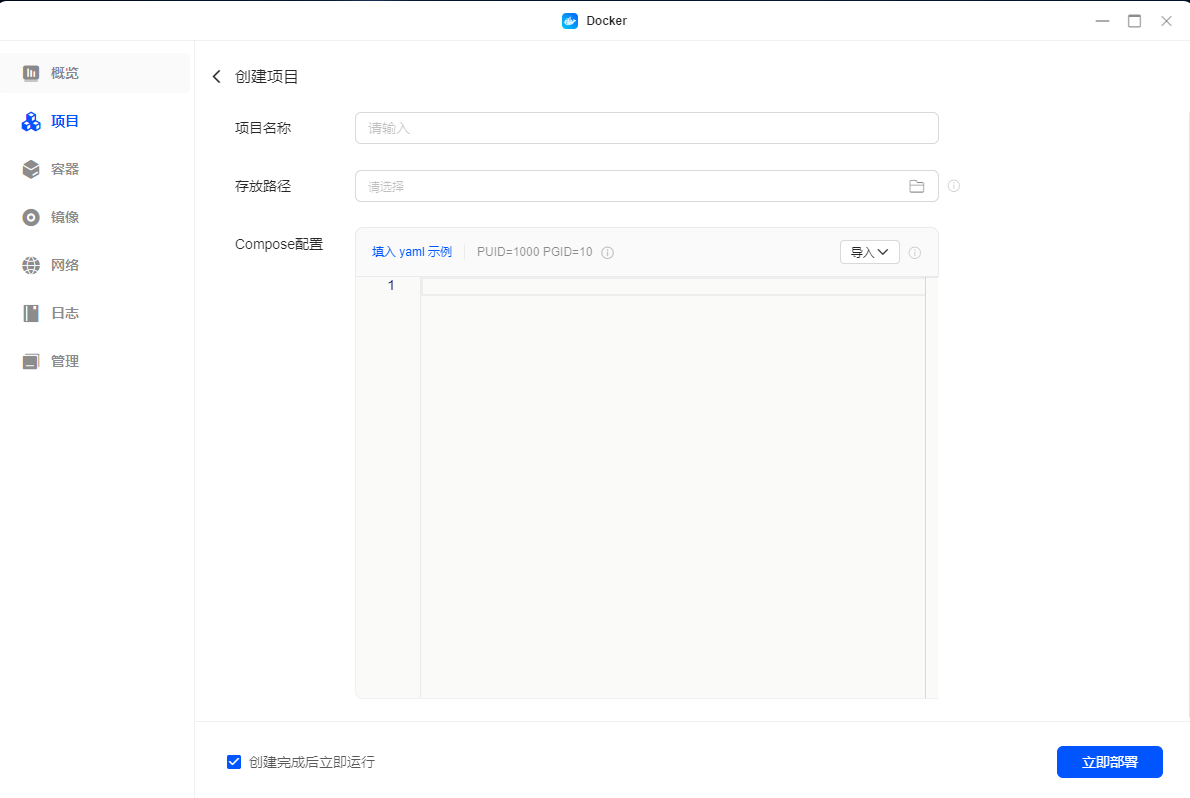

2、部署项目

2.1、创建项目

2.2、Compose配置

services:

ollama:

image: ollama/ollama:latest

container_name: ollama

restart: unless-stopped

ports:

- 11434:11434

networks:

- app_network

tty: true

devices:

- /dev/dri:/dev/dri

volumes:

- ./data:/root/.ollama

networks:

app_network:

external: true3、部署模型

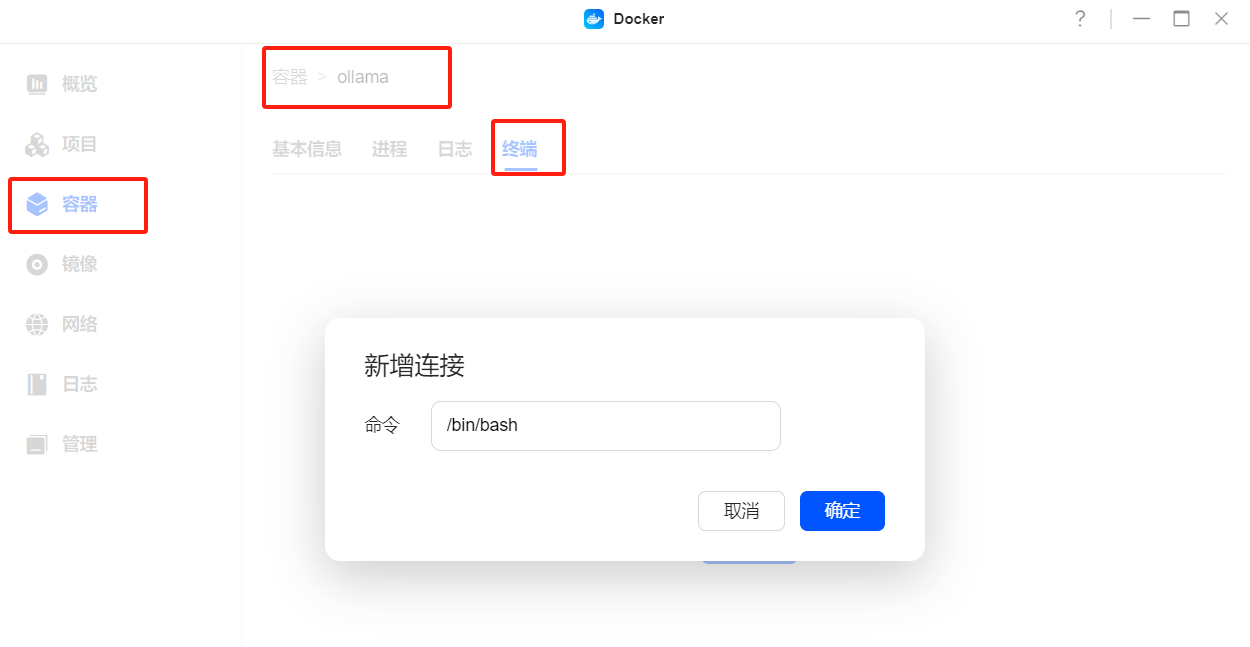

3.1、新增终端连接

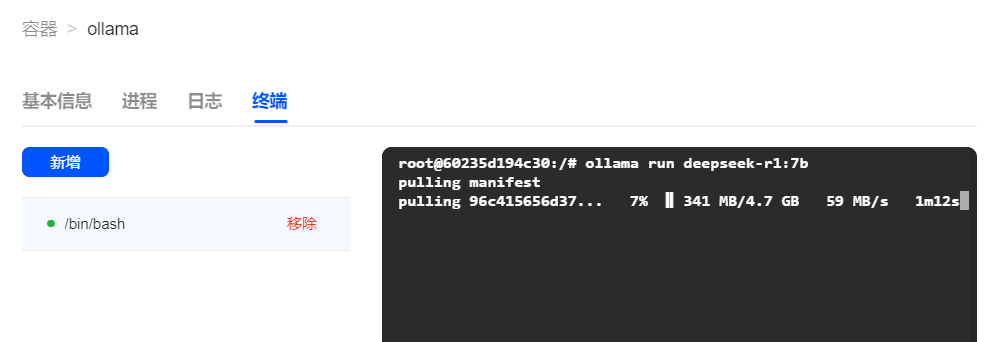

3.2、部署DeepSeek-R1模型

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b在终端界面中执行指令以开始下载相应模型,并等待下载完成。

DX4600设备,建议考虑采用1.5B模型进行体验尝试。